Peter Drucker scriveva: “il computer non prende nessuna decisione; esso esegue solo ordini. È un imbecille totale, e questa è la sua forza. Ci costringe a pensare per impostare i criteri. Più lo strumento è stupido, più noi dobbiamo ingegnarci – e questo è il più stupido strumento che abbiamo mai creato.” Ed era il 1967.

Siamo passati dall’osservare piccole quantità d’informazioni a macchine potentissime che ci forniscono un flusso d’informazioni insostenibile. E non ci rendiamo conto di quanto poco tempo sia passato, tanto da non aver ancora avuto modo di prenderne la misura. La velocità non può far altro che elevare al massimo livello il garbage in/garbage out, letteralmente “Spazzatura Dentro, Spazzatura Fuori”, poiché i Big Data accomunati con la potenza portano naturalmente a questo risultato. A meno di non porre dei filtri.

Ma dove metterli?

– All’ingresso: la raccolta dei dati è una fase fondamentale, perché bisogna scegliere le sorgenti (es. blog, social network, forums, reviews, etc.)

– O all’uscita: parte del processo che usa rappresentazioni grafiche per visualizzare specifiche analisi (per esempio su segmenti di clienti).

In ingresso è difficile perché la quantità è enorme e non si conosce a priori cause e correlazioni tra loro. In uscita si rischia un giudizio di valore, cioè si possono scartare i risultati meno gradevoli, dove c’è meno confidenza della bontà perché ci si può lasciarsi trascinare dal proprio bias.

Tra le due suddette parti c’è il nostro bisogno di conoscenza. Qui è importante definire (e non confondere) il metodo e l’obiettivo di ricerca, che possiamo riassumere in 3 tipi:

– Descrittiva (Che risponde alla domanda: Cosa è successo?)

– Predittiva (Cosa accadrà?)

– Prescrittiva (Cosa dobbiamo fare affinché accada?)

L’analisi descrittiva osserva i dati del passato e evidenzia le ragioni di successi o insuccessi. L’analisi predittiva analizza i dati con lo scopo di predire i comportamenti. L’analisi prescrittiva suggerisce azioni per ottenere i vantaggi dell’analisi predittiva, e rischi per ogni opzione. Usiamo per esempio l’analogia con le mappe per spiegare le differenze tra i tre approcci:

– La descrittiva serve a spiegare il percorso fatto da un punto A al punto B.

– La predittiva serve a stimare come e in quanto tempo si arriva al punto C.

– La prescrittiva dà istruzioni dettagliate, come con il GPS, momento per momento, sulla strada da percorrere.

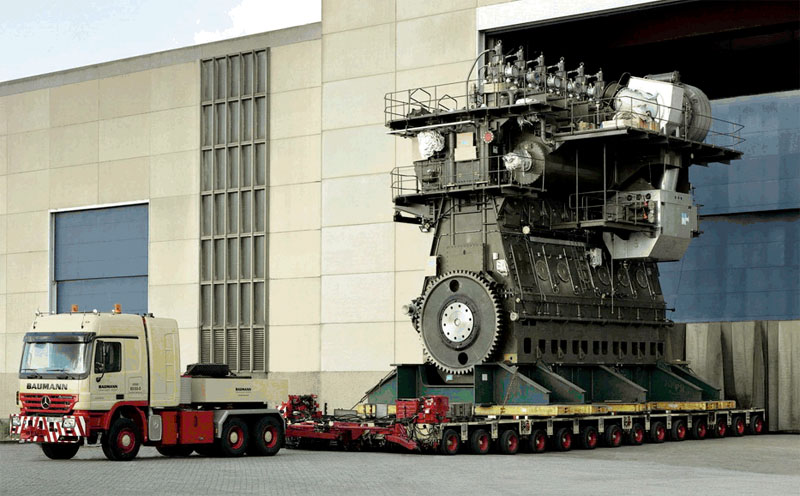

Tutti questi dati devono essere macinati da un enorme motore con grande velocità, e li muove da non strutturati a strutturati (meglio ancora, modellati). Spieghiamo il viaggio che compiono prendendo in prestito la sequenza di Simon Wardley:

Idea = qualsiasi cosa si pensi.

Congettura = idea + alcuni dati a supporto.

Ipotesi Iniziale = idea + dati iniziali + correlazione (attraverso l’osservazione sperimentale) + modelli iniziali di causalità. scarsa fiducia.

Ipotesi Debole = ipotesi iniziale + correlazione dei dati + (supportato da significative osservazioni sperimentali) + causalità + verifica (sia conferme indipendenti o test di previsione).

Ipotesi Consistente = ipotesi debole + grande volume di dati sperimentali confermati + significativa osservazioni (nell’ordine delle centinaia).

Teoria = ipotesi consistente + verifiche (nell’ordine di molte migliaia) da parte della comunità scientifica.

Legge = Teoria + tanti dati + tante verifiche indipendenti.

Per la suddetta sequenza ci vuole tempo, non cerchiamo scorciatoie, soprattutto per scegliere con cura i migliori studiosi (data scientists), affinché il fenomeno dei Big Data, pur utilissimo, non diventi l’inferno delle correlazioni spurie e dei falsi positivi (es. la malattia è assente ma il test è positivo) o falsi negativi (la malattia è presente eppure il test è negativo). Rischiamo che questi enormi motori, con tale velocità nel viaggio ci facciano perdere la cosa più importante, ossia il contesto nel quale dobbiamo prendere le decisioni. Non sono i dati, né le macchine veloci a prendere le decisioni, ma tocca a noi.

“È un fatto universalmente noto che le persone consapevoli e generose generalmente sanno di esserlo, i malvagi e i prepotenti si rendono conto del proprio atteggiamento e anche le vittime più deboli e peggio informate hanno qualche percezione del fatto che qualcosa non va… ma gli stupidi non sanno di essere stupidi – e questo li rende ancora più pericolosi.” Gandalf.it, Il potere della stupidità.

Figurarsi con la potente tecnologia odierna a disposizione che amplifica tutto, stupidità compresa. Ora che il limite tecnologico si è spostato in avanti e il numero di dati è quasi infinito resta il limite umano per capire il nostro limite della comprensione. In tale contesto, affidarsi alla bontà e alla disponibilità di un potente motore tecnologico non ci facilita la vita, forse ce la complica per tutte le decisioni che dobbiamo prendere.

Twitter: @massimochi